MongoDB集群

MongoDB主从复制

主从复制是 MongoDB 最常用的复制方式,也是一个简单的数据库同步备份的集群技术,这种方式很灵活,可用于备份,故障恢复,读扩展等。

最基本的设置方式就是建立一个主节点和一个或多个从节点,每个从节点要知道主节点的地址.。

配置主从复制的注意点

- 在数据库集群中要明确的知道谁是主服务器,主服务器只有一台。

- 从服务器要知道自己的数据源也就是对应的主服务器是谁。

- –master 用来确定主服务器,–slave 和 –source 来控制从服务器。

- 当配置完主从服务器后,一但主服务器上的数据发生变化,从服务器也会发生变化。

master配置文件

创建 master.conf 配置文件,具体内容如下:

dbpath=/usr/local/mongodb/data/master #主数据库地址 port=8888 #主数据库端口号 bind_ip=127.0.0.1 #主数据库所在服务器 master=true #确定我是主服务器 fork=true logpath=/usr/local/mongodb/log/mongodb_master.log

slave配置文件

创建 slave.conf 配置文件,具体内容如下:

dbpath=/usr/local/mongodb/data/slave #主数据库地址 port=7777 #主数据库端口号 bind_ip=127.0.0.1 #主数据库所在服务器 slave=true #确定我是从服务器 fork=true logpath=/usr/local/mongodb/log/mongodb_slave.log source=127.0.0.1:8888 #master的地址 autoresync=true

启动服务器

./mongod --config master.conf ./mongod --config slave.conf

启动客户端

# 启动主库

./mongo 127.0.0.1:8888

# 启动从库

./mongo 127.0.0.1:7777

# 在主库里面写如数据

use master_test

db.tb_master_test.insert({name:"zw", age:1000})

# 在从库里面执行

rs.slaveOk()

db.tb_master_test.findOne() #数据已经同步

主从复制的原理–oplog

在主从结构中,主节点的操作记录成为 oplog(operation log)。oplog 存储在一个系统数据库 local 的集合oplog.$main 中,这个集合的每个文档都代表主节点上执行的一个操作。

从服务器会定期从主服务器中获取 oplog 记录,然后在本机上执行。对于存储 oplog 的集合,MongoDB 采用的是固定集合,也就是说随着操作过多,新的操作会覆盖旧的操作。

MongoDB副本集

副本集的概念

副本集有点类似主从复制,不过跟真正的主从复制还是有两点区别的:

- 该集群没有特定的主数据库。

- 如果哪个主数据库宕机了,集群中就会推选出一个从属数据库作为主数据库顶上,这就具备了自动故障恢复功能。

特点

如果有三台服务器 A,B,C,假设 A 是活跃的 B 和 C 是用于备份的。当 A 出现了故障,这时候集群根据权重算法推选出 B 或者 C 为活跃的数据库。当 A 恢复后他自动又会变为备份数据库。

A节点的配置文件

创建 A.conf 配置文件:

dbpath=/usr/local/mongodb/data/A port=1111 #端口 bind_ip=127.0.0.1 #服务地址 replSet=child/127.0.0.1:2222 #设定同伴 child为集群名称 fork=true logpath=/usr/local/mongodb/log/mongodb_A.log

B节点的配置文件

创建 B.conf 配置文件:

dbpath=/usr/local/mongodb/data/B port=2222 #端口 bind_ip=127.0.0.1 #服务地址 replSet=child/127.0.0.1:3333 #设定同伴 child为集群名称 fork=true logpath=/usr/local/mongodb/log/mongodb_B.log

C节点的配置文件

创建 C.conf 配置文件:

port=3333 #端口 bind_ip=127.0.0.1 #服务地址 replSet=child/127.0.0.1:1111 #设定同伴 child为集群名称 fork=true logpath=/usr/local/mongodb/log/mongodb_C.log

上面三台机器形成了一个闭环,A 的同伴为 B,B 的同伴为 C,C 的同伴为 A。

启动服务器

./mongod --config A.conf

./mongod --config B.conf

./mongod --config C.conf

初始化副本集

# 启动任意一个客户端 ./mongo 127.0.0.1:1111 # 初始化 config = { id: 'child', members: [{ "id":1, "host":"127.0.0.1:1111" },{ "id":2, "host":"127.0.0.1:2222" },{ "id":3, "host":"127.0.0.1:3333" }] } rs.initiate(config);

此时你会发现你当前的 shell 客户端的前缀变了,其中 child:PRIMARY> 表示活跃节点。其余为备份节点。注意:只有活跃节点才能进行查询数据库的信息操作,备份节点不能进行会报错。

在活跃的主机上可以进行 rs.status() 来查看所有状态。

验证

主从服务器数据是否同步,从服务器没有读写权限:

- 向主服务器写入数据 ok 后台自动同步到从服务器,从服务器有数据。

- 向从服务器写入数据 false 从服务器不能写。

- 主服务器读取数据 ok。

- 从服务器读取数据 false 从服务器不能读。

关闭主服务器,从服务器是否能顶替:

- 此时你关掉活跃节点的服务。此时你会发现剩余的两台机器有一台变为活跃节点了。

配置副本集的其他配置参数

节点和初始化高级参数:

| 参数 | 描述 | 说明 |

|---|---|---|

| standard | 常规节点 | 参与投票有可能成为活跃节点 |

| passive | 副本节点 | 参与投票,但是不能成为活跃节点 |

| arbiter | 仲裁节点 | 只是参与投票不复制节点也不能成为活跃节点 |

MongoDB分片

简介

分片技术,跟关系数据库的表分区类似,我们知道当数据量达到 T 级别的时候,我们的磁盘,内存就吃不消了,或者单个的 MongoDB 服务器已经不能满足大量的插入操作,针对这样的场景我们该如何应对。MongoDB 提供的分片技术来应对这种瓶颈。

当然分片除了解决空间不足的问题之外,还极大的提升的查询速度。

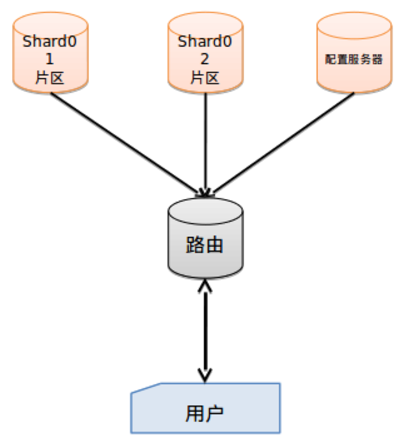

概念

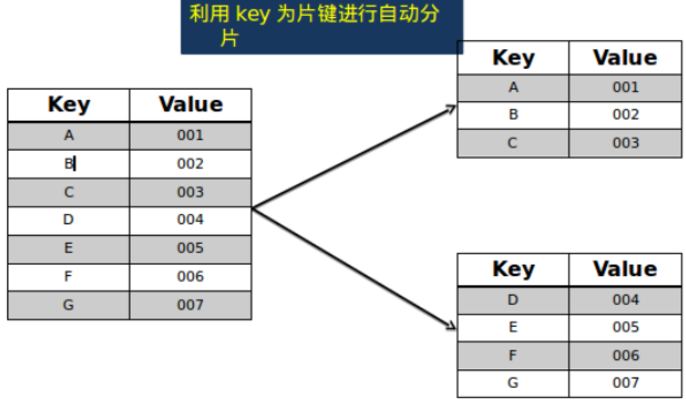

MongoDB 采用将集合进行拆分,然后将拆分的数据均摊到几个片上的一种解决方案。

| 名词 | 说明 |

|---|---|

| 用户 | 代表客户端,客户端肯定说,你数据库分片不分片跟我没关系,我叫你干啥就干啥,没什么好商量的。 |

| 路由 | mongos,首先我们要了解 ”片键“ 的概念,也就是说拆分集合的依据是什么?按照什么键值进行拆分集合。好了,mongos 就是一个路由服务器,它会根据管理员设置的 “片键” 将数据分摊到自己管理的mongod 集群,数据和片的对应关系以及相应的配置信息保存在 ”config 服务器” 上。 |

| 配置服务器 | mongod 普通的数据库,一般是一组而图中我们只画了一个,由路由管理。它的作用是记录对数据分片的规则,存储所有数据库元信息(路由、分片)的配置。 |

| 片区 | 具体的存储信息,根据路由配置的片键不同。 |

片键的概念和用处

创建步骤

创建分片 1 的配置文件 shared1.conf:

dbpath=/usr/local/mongodb/shared_test/data port=8081 bind_ip=192.168.33.135

创建分片 2 的配置文件 shard2.conf:

dbpath=/usr/local/mongodb/shared_test/data port=8082 bind_ip=192.168.33.132

创建配置服务的配置文件,configserver.conf:

dbpath=/usr/local/mongodb/shared_test/data port=2000 bind_ip=192.168.33.133

在配置服务的 mongo 服务器上启动路由:

mongos --port 1000 --configdb 192.168.33.133:2000

分别启动分片服务器:

mongod --config shared1.conf

mongod --config shared2.conf

在配置服务上启动配置服务:

mongo 192.168.33.133:1000

为集群添加分片:

use admin

db.runCommand({addshard:"192.168.33.135:8081",allowLocal:true})

db.runCommand({addshard:"192.168.33.132:8082",allowLocal:true})

打开数据分片功能,为数据库 foobar 打开分片功能:

db.runCommand({"enablesharding":"foobar"})

对集合进行分片:

db.runCommand({"shardcollection":"foobar.bar","key":{"_id":1}})

利用大数据量进行测试:

function add(){ var i = 0; for(;i<200000;i++){ db.bar.insert({"age":i+10,"name":"jim"}) } } function add2(){ var i = 0; for(; i<200000; i++) { db.bar.insert({"age":12,"name":"tom"+i}) } } function add3(){ var i = 0; for(; i<200000; i++){ db.bar.insert({"age":12,"name":"lili"+i}) } }

查看配置库对于分片服务器的配置存储:

db.printShardingStatus()

查看集群对 bar 的自动分片机制配置信息:

db.shards.find()

备注

对于分片是最常用的,实际中的分片不可以像我们配置的这么简单,为了保险,实际中分片之间配置为副本集,配置服务器也不会是单单一台也常见的是一个副本集的集群。只有这样,才能让系统更加健壮。